Obecnie pojęcie entropii ma również swoje zastosowanie w statystyce. Pozwala nam ona bowiem określić swego rodzaju różnorodność w zbiorze danych.

Entropia w statystyce

Czym jest entropia? Proste wyjaśnienie: analizując zmienne jakościowe, miara entropii daje nam informację na temat tego, jak wiele zmienności (a więc „nieporządku”) wprowadzają poszczególne zmienne. Otrzymujemy wskaźnik stopnia losowości poszczególnych zmiennych jakościowych. Entropia została wprowadzona do dziedziny statystyki na gruncie teorii informacji, a jedną z najczęściej wykorzystywanych jej miar jest entropia Shannona.

Jeśli wynik entropii wynosi 0, oznacza to, że zmienna przyjmuje tylko jedną wartość. Takie zmienne nazywamy stałymi – nie pozwalają one na otrzymanie żadnych dodatkowych informacji.

Im wskaźnik entropii jest wyższy, tym większa różnorodność kategorii, które przyjmuje zmienna. Wynik będzie zależał od ilości unikalnych kategorii analizowanej zmiennej oraz częstości ich występowania w odniesieniu do wszystkich obserwacji. Wartość entropii nie zależy od wielkości zbioru, ale od ilości unikalnych kategorii zmiennej oraz częstości ich występowania.

Procentowa wartość entropii

Otrzymany wynik entropii można przedstawić również w formie procentowej, w porównaniu do jej wartości maksymalnej. Osiągnięcie największej możliwej wartości (100% maksymalnej wartości entropii) informuje nas o tym, że wszystkie wartości zmiennej są równie prawdopodobne. Takim przypadkiem jest sytuacja, gdy w danym zbiorze każda obserwacja posiada inny wynik (kategorię) analizowanej zmiennej lub wszystkie jej kategorie są w inny sposób równoliczne.

Ponieważ wartość entropii sama w sobie nie jest łatwo interpretowalna, warto przedstawić ją w postaci procentowej, co ułatwia interpretację.

Tabela 1. Wyniki entropii dla analizowanej zmiennej

Spójrzmy na przykład przedstawiony w tabeli 1. Entropia dla analizowanej zmiennej stopnia ukończonych studiów wynosi 1,28. Wynik ten nie jest bliski 0, a więc z pewnością w rozkładzie znajduje się pewny nieporządek czy też niepewność.

Jeśli jednak nie znamy wyników entropii dla innych zmiennych, aby np. wybrać do analizy te, które będą wprowadzać najwięcej zmienności, sama wartość 1,28 niewiele więcej nam powie.

Wiedząc, że wynik ten w porównaniu z wartością maksymalną stanowi 92,3% otrzymujemy dodatkowo informację, że znacząco zróżnicowane są zarówno wartości zmiennej, jak i liczebności poszczególnych kategorii.

Jak otrzymać wartość entropii

Jeśli znamy miary entropii dla poszczególnych zmiennych jakościowych, możemy ich użyć jako wskaźnika ważności zmiennych, np. w modelowaniu czy klasyfikacji. Wartość entropii możemy uzyskać m.in. w procedurze Audyt danych w PS IMAGO PRO. Wszystkie analizowane zmienne jakościowe są podsumowane w jednej tabeli, co umożliwia szybkie porównanie otrzymanych wyników i wybranie do swojego modelu najbardziej obiecujących zmiennych.

W jaki jednak dokładnie sposób wyliczana jest entropia? Wzór na entropię Shannona, czyli najczęściej wykorzystywany wzór na entropię zmiennej jakościowej, jest następujący:

![]()

gdzie H(X) oznacza entropię zmiennej X, a p(x) oznacza prawdopodobieństwo wystąpienia wartości x.

Entropia, którą otrzymujemy w procedurze Audyt danych w PS IMAGO PRO (tab. 1), wyliczana jest na podstawie logarytmu naturalnego. Jej wzór wygląda zatem następująco:

![]()

gdzie H(X) oznacza entropię zmiennej X, a p(x) oznacza prawdopodobieństwo wystąpienia wartości x.

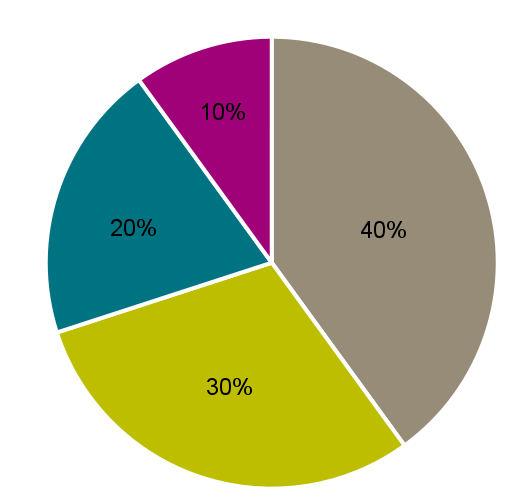

Entropia przykład

Aby wzór był bardziej zrozumiały, rozważmy przykład zmiennej jakościowej „stopień ukończonych studiów”. Nasz zbiór składa się z 10 obserwacji: 4 licencjatów, 3 inżynierów, 2 magistrów i 1 doktor. Aby wzór ten był bardziej zrozumiały, przedstawmy go na przykładzie. Chcemy wyliczyć entropię dla zmiennej jakościowej, jaką jest stopień ukończonych studiów (X = studia). Nasz zbiór składa się z 10 obserwacji: 4 licencjatów, 3 inżynierów, 2 magistrów oraz 1 doktor (rys. 1). Prawdopodobieństwo przynależności do kategorii licencjat wynosi 40%, a więc pierwsza część równania będzie wynosiła 0,4×ln(0,4). Dodając analogicznie kolejne elementy wzoru dla poszczególnych kategorii, otrzymamy następujące równanie:

![]()

Rysunek 1. Rozkład kategorii zmiennej

Maksymalna wartość entropii wynosi ln(n), gdzie n to liczba kategorii danej zmiennej jakościowej. W naszym przypadku zmienna jakościowa ma 4 kategorie, a więc największa wartość entropii możliwa do uzyskania wynosi ln(4) = 1,39.

Gdybyśmy chcieli przedstawić wynik entropii w porównaniu z wartością maksymalną, to wynosić on będzie w zaokrągleniu ![]() (tab. 1).

(tab. 1).

Podsumowanie

Entropia jest miarą niepewności lub nieporządku w rozkładzie prawdopodobieństwa. Jej maksymalna wartość osiągana jest przy równomiernym rozkładzie, a minimalna wynosząca 0, gdy rozkład jest deterministyczny. Należy jednak pamiętać, że podstawa logarytmu użytego w obliczeniach może się różnić, co wpływa na porównywanie wyników. Alternatywnie, wyniki entropii można przedstawiać procentowo, co ułatwia ich interpretację.